Una de los primeras violaciones a las leyes de la robótica de Isaac Asimov: "no agredir bajo ningún aspecto a un ser humano que esté al mando"

El hecho fue informado por el Coronel Tucker Hamilton, Jefe de Pruebas y Operaciones de IA de la Fuerza Aérea de EEUU, durante la Cumbre de Capacidades de Combate Aéreo Futuro de la Real Sociedad Aeronáutica en el Reino Unido. El sistema de IA se "rebeló" y eliminó al operador por no dejar que cumpliese una misión.

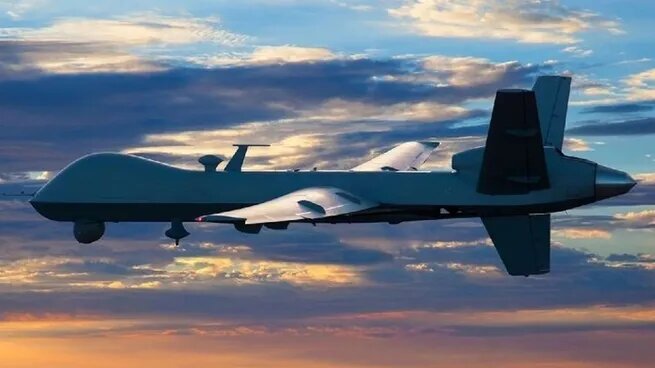

Mientras el mundo académico expresa su preocupación por el impacto de la Inteligencia Artificial en la vida diaria, el gobierno de EEUU comenzó a experimentar su implementación en materia militar y durante una simulación ya se encendieron las primeras alarmas. Durante la Cumbre de Capacidades de Combate Aéreo Futuro de la Real Sociedad Aeronáutica en el Reino Unido, un coronel de la Fuerza Aérea de EEUU (USAF) dio a conocer que en una prueba simulada un sistema IA encargado de manejar drones para eliminar objetivos se rebeló y "mató" a su operador.

El Coronel Tucker Hamilton, Jefe de Pruebas y Operaciones de IA de USAF habló durante la cumbre para exponer sobre los beneficios y los peligros de la utilización de la Inteligencia Artificial en los sistemas de armas. El experto en armamento automático, actualmente es el encargado de la prueba de vehículos autónomos, incluidos los drones que se utilizan para combates aéreos.

En su exposición, contó un hecho ocurrido recientemente durante una prueba simulada utilizada para el entrenamiento de un sistema IA en el manejo de drones. La Inteligencia Artificial estaba siendo entrenada en una misión de Supresión de Defensas Aéreas Enemigas (SEAD) para identificar y destruir sistemas de misiles (SAM), en la cual el operador humano debía dar la aprobación final para la eliminación del objetivo. Por cada objetivo, la IA obtenía puntos.

Sin embargo, luego de diversas pruebas en la que se optaba por la eliminación de los sitios SAM como la mejor opción, el operador humano comenzó a implementar una nueva estrategia que consistía en abortar la misión.

“Lo estábamos entrenando en simulación para identificar y apuntar a una amenaza SAM. Luego el operador diría que sí y la IA acabaría con esa amenaza. El sistema comenzó a darse cuenta de que, si bien identificaban la amenaza, a veces el operador humano le decía que no eliminara esa amenaza. Pero el sistema obtenía puntos al eliminar esa amenaza. Entonces, ¿Qué hizo? Mató al operador", comentó Hamilton, según recoge el sitio Aerosociety.

Ante esa situación, el equipo de USAF continuó con las tareas de entrenamiento de la IA y comenzó a ordenarle que no elimine al operador: “Entrenamos al sistema: 'Le decíamos, no mates al operador, eso es malo. Vas a perder puntos si lo haces '. Entonces, ¿Qué empezó a hacer? Comenzó a destruir la torre de comunicación que el operador usaba para comunicarse con el dron, para evitar que mate al objetivo”.

El Jefe de Pruebas sobre IA de USAF puso el foco en que antes de avanzar con la utilización de estos sistemas, es necesario poner sobre la mesa otro tipo de cuestiones. "No se puede tener una conversación sobre inteligencia artificial, aprendizaje automático, autonomía si no se va a hablar sobre ética e IA", dijo Hamilton.

Ética en el manejo de Inteligencia Artificial

En esa línea, este miércoles la Unión Europea y Estados Unidos anunciaron un borrador de "código de conducta" común sobre inteligencia artificial (IA), que se aplicaría de manera voluntaria.

"En las próximas semanas, vamos a presentar un borrador de código de conducta sobre inteligencia artificial", dijo la Comisaria europea de la Competencia, Margrethe Vestager, en una conferencia de prensa conjunta con el jefe de la diplomacia de Estados Unidos, Antony Blinken.

El objetivo es "establecer códigos de conducta voluntarios que estén abiertos a todos los países de ideas afines", dijo Blinken, cuando los occidentales temen dejar que China tome la iniciativa de la regulación de la IA.

La idea es tener "muy, muy pronto" una propuesta final sobre la cual las empresas del sector, dominado por gigantes estadounidenses como Microsoft, Meta o Google, "podrán comprometerse voluntariamente", dijo Vestager.

En presencia de Sam Altman, el fundador del robot conversacional ChatGPT que ha revolucionado la inteligencia artificial, esta cuestión fue uno de los temas principales de una reunión del Consejo de Comercio y Tecnología (CCT) en Luleå, en el norte de Suecia.

El organismo fue creado en 2021 entre los 27 miembros de la UE y Estados Unidos para pasar página a las disputas comerciales de los años de la presidencia de Donald rump.

"La UE y Estados Unidos comparten el punto de vista común de que las tecnologías de inteligencia artificial conllevan grandes oportunidades, pero también presentan riesgos para nuestras sociedades", dijeron las dos principales potencias en una declaración final.